Od kilku lat, w branży elektronicznej rozrywki, obserwujemy bardzo niepokojące zjawisko. Gry komputerowe stają się rozrywką ekskluzywną, dostępną jedynie wybranym (czyt. zamożnym) ludziom. Minęły już bezpowrotnie czasy, kiedy to można było zagrać w najnowszą grę, bez potrzeby ciągłej i kosztownej wymiany prawie całego sprzętu.

|

|

Na początku lat dziewięćdziesiątych, kiedy to gry komputerowe w naszym kraju wchodziły w fazę bardzo szybkiego rozwoju, prawie każdy nastolatek miał z nimi styczność. Mało tego, wielu z nich miało komputery w domu i katowało na nich swoje ulubione tytuły. Działo się tak pomimo tego, że sam zakup jakiegokolwiek „nowoczesnego” komputera typu Amiga czy PC klasy 386 był, w tamtym czasie, ogromnym wydatkiem, poważnie nadwerężającym domowy budżet.

Kiedy, mimo wszystko, udało się pokonać te początkową przeszkodę (wbrew pozorom wielu się to udawało, niech świadczy o tym choć by fakt jak wiele pojawiło się w tamtym czasie pism traktujących o grach i samych komputerach) dalsza eksploatacja kompa była już bardzo tania. Polegała, w zasadzie tylko i wyłącznie na dosyć częstych wymianach zużytych vel. połamanych „joy'ów”.

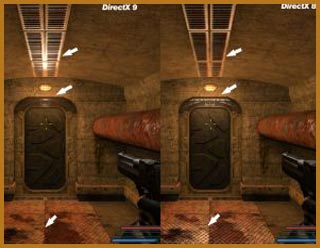

(kliknij aby powiększyć)

„Powalające” różnice pomiędzy DirectX 8.1, a DirectX 9.0

Żywotność komputerów dochodziła wtedy do kilku lat. Można było, na tym samym sprzęcie, przez pięć kolejnych „wiosen”, bez większych problemów grać w 95% nowych gier.

Sytuacja zaczęła się zmieniać gdzieś około roku 1994/1995 kiedy to coraz popularniejsze stawały się nowe procesory Intela, o nazwie Pentium.

Posiadacze starszych modeli pecetów typu 386/486, chcących grać w nowe gry, zostali zmuszeni do zmiany procesora, a co za tym idzie i płyty głównej, ponieważ nowy CPU korzystał z innego typu gniazda aniżeli poprzednicy. Ale znowu był to wydatek jednorazowy, który pozwalał na przedłużenie żywota blaszaka o kolejne 3 lata. W połowie roku 1997 nastąpiło coś co z początku wydawało się wielkim przełomem (i w dużej mierze nim było), mianowicie pojawił się akcelerator graficzny 3Dfx VooDoo.

„Jak te włosy piknie falują” however… who gives a shit ?!?

Był to pierwszy akcelerator 3D z prawdziwego zdarzenia, oferował nie tylko szereg niedostępnych wcześniej funkcji, ale naprawdę dawał blaszkakowi porządnego kopa pozwalając mu wreszcie dogonić a nawet, dość znacznie wyprzedzić, ówczesne super konsole Sony PlayStation i Segę Saturn. Wszyscy niemal z miejsca rzucili się do sklepów, z jedną tylko myślą w głowie: „ Musze mieć to cacko w swoim kompie ”.

W tej sytuacji aż ciśnie się na usta stare powiedzenie „Miłe złego początki”. Premiera „Wudulca”, jak go wtedy nazywano, nie tylko zrewolucjonizowała rynek sprzętu, ale także i może przede wszystkim zmieniła rynek gier, który nigdy nie miał już być taki sam jak przedtem.

Około dwunastu miesięcy po premierze pierwszego VooDoo, firma 3Dfx wypuściła na rynek jego następcę, akcelerator graficzny z serii VooDoo 2.

Wprowadzenie nowego rozwiązania spowodowało spadek cen poprzedniego, co było jak najbardziej na rękę ówczesnym graczom, ponieważ coraz więcej gier wymagało do działania akceleratora VooDoo. Widząc ogromny potencjał jaki tkwił w nowo kształtującym się rynku również i inne firmy zaczęły tworzyć, promować i sprzedawać swoje akceleratory grafiki trójwymiarowej. Wystarczy tu wspomnieć chociażby o nVIDII i jej kartach z serii Riva, czy ATI i jego Rage’u.

|

Od roku 1999 nowe karty graficzne zaczęły pojawiać się średnio co 7-8 miesięcy. W jednym czasie pojawiało się nawet pięć wariantów tej samej karty, różniących się ceną i osiągami. Producenci gier nie nadążali za bardzo szybkim rozwojem akceleratorów nie implementując do swych gier nawet połowy funkcji jakie oferowały najnowsze karty graficzne.

Cudowna twarzyczka, szkoda tylko, że będę musiał ją rozwalić

Zaczęli za to robić coś innego, a mianowicie w ogóle przestało im zależeć na tak zwanej optymalizacji kodu gry. Do historii przeszły wtedy czasy, kiedy to nad każdą linijką programista siedział po kilka godzin optymalizując ją tak aby całość działała jak najlepiej nawet na średniej klasy sprzęcie.

Mniej więcej w tym samym czasie, czyli w roku 1999, bardzo popularne stały się różnego rodzaju benchmarki graficzne, czyli programy testujące wydajność komputerów, zwłaszcza zaś kart graficznych w środowisku 3D. Najpopularniejszymi z nich stały się programy z serii 3D Mark firmy MadOnion. Spowodowało to, ponowne skrócenie czasu oczekiwania na kolejne „cuda techniki” spod znaku nVIDIa GeForce czy ATI Radeon i co za tym idzie jeszcze większe rozleniwienie programistów tworzących gry.

Wszystko to doprowadziło do sytuacji, jaką mamy dzisiaj. Nowe karty graficzne pojawiają się w zasadzie co 5-6 miesięcy. Implementuje się w nich coraz to nowe technologie, najczęściej wykorzystywane jedynie w benchmarkach, a jeśli nawet już można je zobaczyć w grach to przeważnie w produkcjach typu FPP (tylko proszę mi wytłumaczyć, kto do k#@y nędzy ma czas podziwiać jak pięknie falują liście na drzewach kiedy gra w jakiegoś FPP po sieci ?!?).

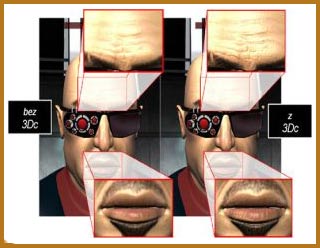

Nowa, fantastyczna technologia C2H5OH… sory 3Dc

Wszystko to dałoby się jeszcze jakoś znieść jeśli tak szybkie premiery prowadziły do znacznego spadku cen poprzednich rozwiązań. Jednak nic podobnego nie ma miejsca. Żeby wyraźnie odczuć spadek ceny karty graficznej od czasu jej premiery musi upłynąć co najmniej 7-8 miesięcy. Niestety, jeśli nawet uda nam się zakupić wtedy takie „cudo” to i tak będzie już ono zbyt przestarzałe, żeby zapewnić płynną zabawę najnowszym tytułem w jakichś rozsądnych ustawieniach jakości obrazu.

Doskonałym przykładem tego, co się obecnie dzieje są długo oczekiwane gry DOOM 3 i HALF LIFE 2. Nie dość, że ich premiery były lub nadal są ciągle przekładane, to jeszcze ich wymagania sprzętowe są wręcz kosmiczne i nie do spełnienia przez przeciętnego gracza. Co jeszcze „ciekawsze”, wytwórcy hardware’u podpisują różnego rodzaju przedziwne umowy z producentami gier, na temat tego, że to właśnie na ich sprzęcie dany tytuł będzie działać najlepiej. Może dojść nawet do tak absurdalnej sytuacji, że aby pograć we wszystkie najnowsze gierki trzeba będzie mieć, w domu, nie tylko najnowszy sprzęt, ale także dwie karty graficzne dwu różnych producentów ?!?

Do czego to wszystko może doprowadzić ???

Gracze nie mogąc już nadążyć za tym wszystkim nie tylko finansowo ale także nerwowo, mogą nie wytrzymać i przerzucić się na tańsze w „utrzymaniu” konsole. Co w dalszej konsekwencji może doprowadzić do całkowitego wyeliminowania gier z platformy PC (ponieważ nikogo już nie będzie stać na taką zabawę ).

Cóż pozostaje mi tylko życzyć Wam i sobie, żeby te moje czarne proroctwo nigdy się nie sprawdziło. Powodzenia w nowym roku szkolnym i do przeczytania za miesiąc.

PS. Wielu z Was, a przede wszystkim najmłodsze pokolenie graczy może uznać ten artykuł za herezje. Jednak trzeba wziąć pod uwagę, że napisał go człowiek, który pamięta jeszcze stare dobre czasy zwane „ Złotą erą gier komputerowych” , która w kraju nad Wisła rozpoczęła się na przełomie lat osiemdziesiątych i dziewięćdziesiątych, a skończyła gdzieś około roku 1997.

PS2. Obiecany w SS-NG 22 test Radeona X800, ukaże się w następnym miesiącu (jeśli oczywiście dożyje ;])

PS3. Wielkie tnx dla kolegi Rem'X’a za korektę.

|

|

|

|